Guten Tag,

wir haben drei Kubernetes Cluster und nutzen den Kubernetes Special Agent mit Installation nach folgender Anleitung: Kubernetes überwachen

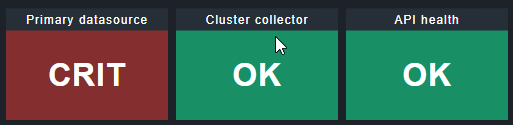

In zwei der drei Cluster funktioniert die Installation des Helm-Charts super und die Anbindung funktioniert in CheckMK. Das eine Cluster hat aber das Problem, dass ich folgende Meldung im CheckMK erhalte:

[special_kube] Agent exited with code 1: 401, Reason: Unauthorized, Message: UnauthorizedCRIT, Got no information from hostCRIT, execution time 1.0 sec

Ein ähnliches Thema habe ich bereits gefunden, das Problem scheint aber nicht ganz das Gleiche zu sein, eine Lösung konnte ich so jedenfalls nicht herbeiführen: Kubernetes 401 unauthorized

Ich habe herausgefunden, dass der ServiceAccount der durch das Helm-Chart installiert wird, keine Secrets erstellt. Jedenfalls bekomme ich beim ausgeben des Zertifikats keinen Inhalt mehr zurück:

~$ helm ls

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION

checkmk-clustercollector checkmk-monitoring 1 2022-11-08 14:37:28.686005087 +0100 CET deployed checkmk-1.1.0 1.1.0

~$ kubectl get serviceaccounts

NAME SECRETS AGE

checkmk-clustercollector-checkmk 0 20m

checkmk-clustercollector-cluster-collector 0 20m

checkmk-clustercollector-node-collector-container-metrics 0 20m

checkmk-clustercollector-node-collector-machine-sections 0 20m

default 0 4h20m

~$ export CA_CRT="$(kubectl get secret $(kubectl get serviceaccount checkmk-clustercollector-checkmk -o=jsonpath='{.secrets[].name}' -n checkmk-monitoring) -n checkmk-monitoring -o=jsonpath='{.data.ca\.crt}' | base64 --decode)";

~$ echo "$CA_CRT"

~$

Folgende Versionen setze ich ein (die Kubernetes Cluster sind alle gleich installiert, OS wie Kubernetes Versionen)

- Ubuntu 20.04 LTS

- Kubernetes 1.24.6

- Helm v3.10.1

- Helm Chart checkmk-1.1.0 und App Version 1.1.0

Information zur Values-Datei:

Die Values-Datei habe ich komplett aus dem Chart übernommen und nur die Ingress-Ressource angepasst.

Hat jemand eine Idee warum hier keine Secrets für die Service-Accounts erstellt werden und somit die Anbindung nicht funktioniert? Mehrmaliges entfernen inklusive Namespace hat leider keine Besserung gebracht.

Gruß Atomique